1 简介

北京二手房交易数据分析平台:收集二手房交易数据,利用大数据技术进行处理,大屏展示结果 。

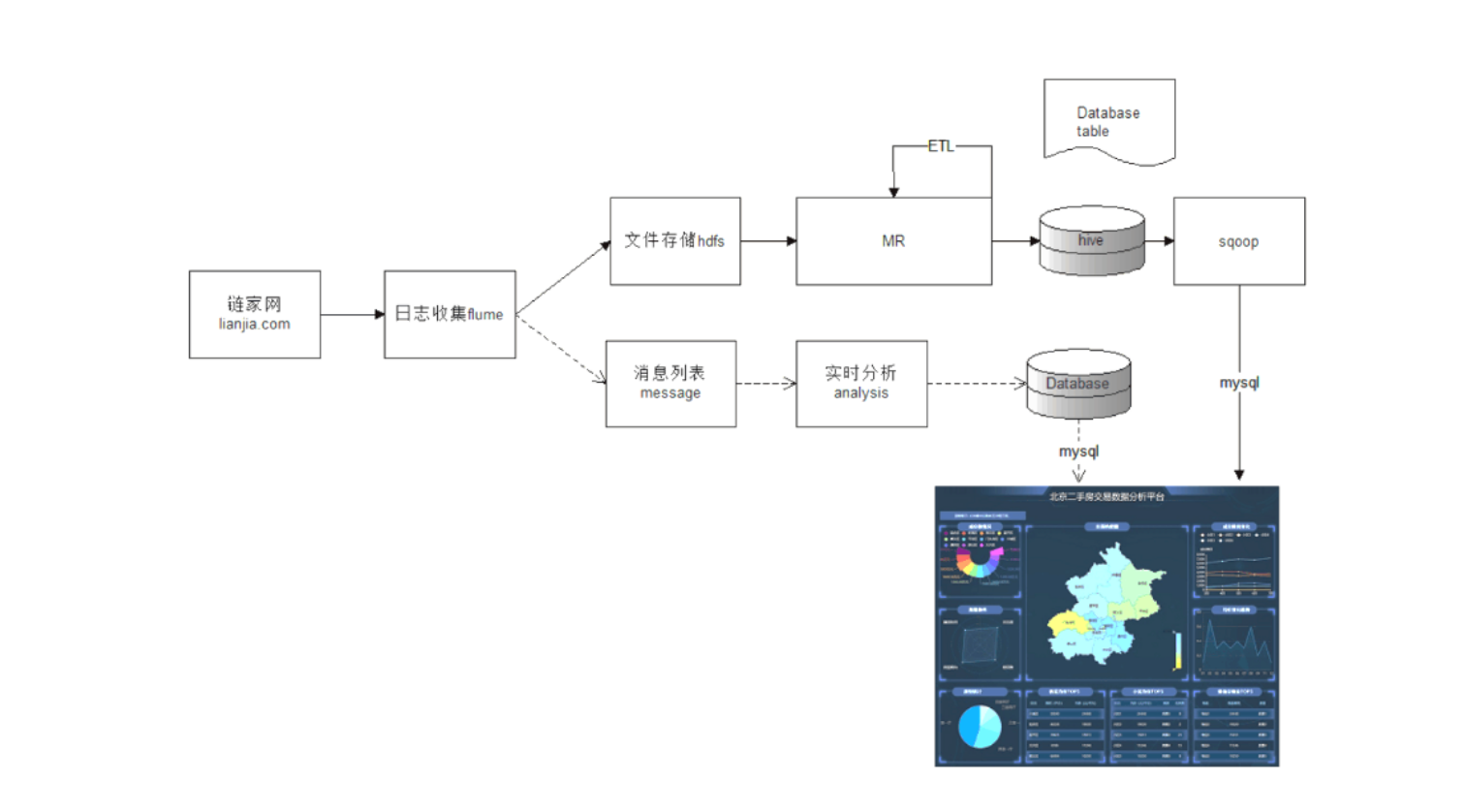

2 工作流程

- 数据收集:爬取二手房交易网站的数据(链家、贝壳等)

- 数据预处理:不同的数据源,不同的数据结构,垃圾数据,对收集到的大数据集合进行预处理

- 数据存储、处理与分析(我负责):搭建hadoop环境,将数据文件上传hdfs,通过mapreduce进行数据分析等

- 数据可视化:后端使用java、前端使用echarts模板等进行展示

3 负责

- 集群:3台centos虚拟机

- 名词解释:

- hadoop:Hadoop是一个能够对大量数据进行分布式处理的软件框架。 https://baike.baidu.com/item/Hadoop/3526507

- hdfs:分布式文件系统 https://baike.baidu.com/item/hdfs/4836121

- mapreduce:是一种编程模型,用于大规模数据集(大于1TB)的并行运算 https://baike.baidu.com/item/MapReduce/133425

- hive:Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供类SQL查询功能。 https://developer.aliyun.com/article/100911

- sqoop:主要用于在Hadoop(Hive)与传统的数据库(mysql、postgresql…)间进行数据的传递 https://baike.baidu.com/item/sqoop/5033853

- hadoop:Hadoop是一个能够对大量数据进行分布式处理的软件框架。 https://baike.baidu.com/item/Hadoop/3526507

4 项目架构图

5 困难

- hadoop集群搭建失败:版本没用对